File - точната настройка индекс на сайта си в Яндекс и Google

Първото нещо, което за търсене бот, който идва към вашия сайт, тя търси и чете файла robots.txt. Какво е файла robots.txt - набор от инструкции за търсачката. Това е текстов файл, който се намира в главната директория на сайта. Този файл показва на робота, че индексът на сайта и това, което не е така. Просто посочете главното огледало на обекта и къде да търсят картата на сайта.

Защо се нуждаете от този файл? За правилното индексиране на вашия сайт. Каквато и да е находка не се дублират страници, на различните страници и офис документи. След като конфигурирате правилно директиви в robots.txt Вие ще спестите вашия сайт от много проблеми с индексирането и zazerkalivaniem сайт.

Как да направите правилния robots.txt

Създаване на robots.txt доста лесно, създаване на текстов документ в Notepad на Windows. Писане в този файл директиви за търсачките. След това запазете файла под името «роботи" или от текст разширяването. Всичко сега е да попълните за провеждане на главната папка на сайта. Моля, обърнете внимание, само един robots.txt може да се създаде за един сайт. Ако този файл не е достъпен на място, ботът автоматично "реши", че може да индексира всички.

Тъй като той е един, а след това има писмени инструкции до всички търсачки. И това може да се запише като отделен инструкция за всяка абонатна станция и общото право в съответствие с него. Разделяне на инструкции за различни роботите на търсачката, се осъществява чрез директивата за потребителския агент. Ние говорим повече за това по-късно.

директиви на robots.txt

Файлът robots.txt може да съдържа следните директиви за контрол на индексирането: User-агент, забранете, Позволете, Карта на сайта, домакин, Crawl-закъснение, почистване Парам. Нека да разгледаме всяка инструкция в детайли.

директива User-Agent

директива User-Agent - точки са инструкции (или по-скоро към даден робот) до търсачката. Ако има "*" след указанията са предназначени за всички роботи. Ако посочите конкретен робот, например чрез Googlebot, след указания са само за основната роботът Google индексиране. И ако има инструкции и отделно за Googlebot и за всички останали членки, от Google само за четене ръководства, както и общи пренебрежение. Yandex бот ще направи същото. Вижте примери за запис на директивата.

User-Agent: YandexBot - инструкции са за основен индексиране бот Yandex

User-Agent: Yandex - инструкции за всички Yandex бот

User-Agent: * - инструкции за всички роботи

Забрани и Позволете директиви

Директива Забрани и Позволете - позволи на екипа, че индекс, и това, което не е така. Забрана не инструктира да индексира страница или раздел на сайта. А Оставете обратното показва, че искате да се индексират.

Disallow: / - забранява индекс целия сайт

Disallow: / papka / - забранява индекса цялото съдържание на папка

Забрани: /files.php - забранява files.php индексен файл

Позволете: / CGI-бен - позволява индексни страници CGI-бен

В Забрани и да позволи на директивите може да бъде, а често и просто трябва да се използват специални знаци. Те трябва да се определят на регулярни изрази.

Специални знаци * - заместители на последователност от знаци. Той приписва по подразбиране до края на всяко правило. Дори и да не са регистрирани, за себе си на SS Съдия-изпълнители. Пример за приложение:

Забрани: /cgi-bin/*.aspx - забранява индекс на всички файлове с разширение .aspx

Disallow: / * Foto - да се забрани индексирането на файлове и папки, които съдържат думата Foto

Специални знаци $ - отменя този знак "*" в края на правилата. Например:

Disallow: / например $ - забранява на индекса "/ например", но и не забранява "/example.html"

И ако $ предписват работата на обучение без маска вече различно:

Disallow: / например - и забранява "/ например" и "/example.html"

Карта на сайта Директива

Карта на сайта директива - има за цел да покаже, търсачката робот, в кое място се намира на картата на хостинг сайт. карта на сайта формат трябва да бъде sitemaps.xml. Карта на сайта нужда от по-бързо и пълно индексиране на вашия сайт. И картата на сайта, не е задължително един файл, може да има няколко. Директиви Записване формат:

Карта на сайта: /sitemaps1.xml

Карта на сайта: /sitemaps2.xml

директива Host

Директива домакин - показва основната огледало сайта на робот. Това не е имало огледала в сайта на индекс, винаги трябва да уточни настоящата директива. Ако тя не посочва Yandex индекс робот воля поне две версии на един сайт с и без WWW. Докато zerkalschik робот те не са залепени. Пример записи:

Водещ: www.seob.info

Водещ: seob.info

В първия случай, индексът на робот воля версията с WWW, във втория случай не. Разрешена да предписват само една директива домакин в robots.txt. Ако посочите номера на тях, ботът ще обработи и ще вземе под внимание само на първия.

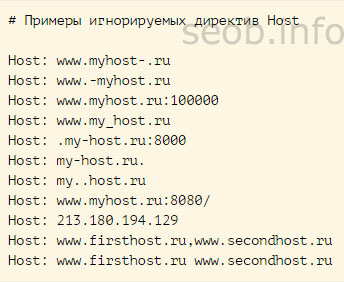

Не е правилно направено от директивата просто ще бъдат игнорирани.

директива Crawl-закъснение

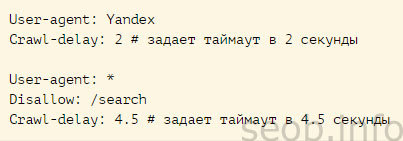

директива Crawl-забавяне намалява натоварването на сървъра. Той е необходим в случай вашия сайт започва да отиде под натиска на различни ботове. Crawl-закъснение директива определя бот търсене времето за изчакване между края на инжектиране на една страница и началото на инжектиране на другите страници на вашия сайт. Директивата трябва да е непосредствено след записите на директиви «Disallow» и / или «Разреши». Yandex робот за търсене може да се използва за четене дробни стойности. Например: 1.5 (половин секунда).

Директива Clean-Парам

Директива Clean-Парам желано място, страниците, които съдържат динамични параметри. Ние говорим за тези, които не влияят на съдържанието на страниците. Това е различна информация услуга: идентификационни номера на сесиите, потребител, референт и т.н. Така че няма да се дублират тези страници и да използва тази директива. Тя казва, че държавите-членки не се качите отново информацията получава. И се намали натоварването на сървъра, и при обхождане на робот сайт.

Clean-Парам: а /forum/showthread.php

Този пост казва PS, че параметър те се счита за незначителен за всички URL Не, това започнете с /forum/showthread.php. Максималната дължина на запис 500 знака.

На директивите разбират, продължете с персонализирането подават нашите роботи.

Създаване на robots.txt

Преминете направо към настройката на файла robots.txt. Той трябва да съдържа най-малко два записа:

User-Agent: - точки на търсачката ще се изпълняват инструкциите по-долу.

Забрани: - уточнява коя част от сайта не се индексират. Могат да бъдат обхванати от индексирането като един сайт страница или на цели секции.

И това е възможно да се отбележи, че тези насоки са предназначени за всички търсачки, или която и да е по-специално. Посочва това в директивата за потребителския агент. Ако искате да прочетете инструкциите, всички роботи - постави "звезда"

Ако искате да се регистрирате инструкции за конкретен робот, но е необходимо да се посочи името си.

А опростен пример на коректен файл robots.txt изглежда така:

User-Agent: *

Забрани: /files.php

Disallow: / Раздел /

Водещ: seob.info

Когато, * се казва, че инструкциите са за всички абонатните станции;

Забрани: /files.php - предвижда забрана за file.php индексиране на файлове;

Disallow: / Foto / - забранява индексирането на целия целия раздел «Foto» с всички прикачени файлове;

Водещ: seob.info - показва, роботи, които индекс огледалото.

Ако няма страниците на сайта си, че е необходимо да се изключи индексирането му, а след това файла robots.txt, трябва да бъде:

User-Agent: *

Забрани:

Водещ: seob.info

Robots.txt за Yandex (Yandex)

Това би означавало, че тези инструкции са за търсачката Yandex, е необходимо да се определи в директива User-Agent: Yandex. И ако ние предписват «Yandex» сайтът ще индексира всички роботи Yandex, и ако ние се посочи «YandexBot» - това ще бъде екип само за основната индексиране робота.

Освен това е необходимо да се определи директива «Водещ», който задаване на първичния огледало сайт. Както написах по-горе, това се прави за да се избегнат дублиращи се страници. Вашето право да robots.txt Yandex е:

User-Agent: Yandex

Disallow: / CGI-бен

Disallow: / adminka

Водещ: seob.info

Карта на сайта: /sitemaps.xml

До сега често чуваме въпроси, по-добре е да се уточни домакин в директивата, сайтът със или без WWW. Но няма значение. Тук просто, колкото искате, че сайтът ще изглежда да издаде PS. Важно е не забравяйте да го зададете на всички, които не биха се създаде дубликати.

Robots.txt за Google

Google търсачката поддържа всички разпространени формати за запис на robots.txt файл. Вярно е, че той не счита, директивата за домакин. Ето защо, разлики от Yandex, всъщност няма. Robots.txt за Google ще бъде, както следва:

User-Agent: Googlebot

Disallow: / CGI-бен

Disallow: / adminka

Карта на сайта: /sitemaps.xml

Надявам се, че информацията, която съм посочен ще бъде достатъчно, за да се създаде високо качество и най-важното правилния файл. robots.txt. Ако използвате един от най-популярните CMS в следващата статия, аз ви подготвили селекция от роботи - robots.txt за популярна CMS